Guten Tag,

ein

Sensor, der in den meisten kleinen Digitalkameras heutzutage verwendet wird, hat auf jedem Pixel einen Farbfilter aufgedampft. Dabei werden abwechselnd

Rot,

Grün und

Blau verwendet, wobei Grün oftmals mengenmäßig doppelt vorhanden ist, um dem natürlichem Empfinden des Menschen entgegen zu kommen.

Bayerpatternfilter (fspg2)

Die obige Abbildung zeigt nur einen Ausschnitt von 4 Pixel x 4 Pixeln. Bei einer 6 Megapixelkamera haben wir z.B. eine Anordnung von 3000 Pixel x 2000 Pixel und jetzt das Beste: diese Pixel liegen auf einer Fläche von

(je nach Sensorhersteller und Sensorgröße verschieden) nur wenigen

Quadratmillimetern .

Je kleiner aber die Pixelgröße (

die im Mikrometerbereich liegt) und je kleiner die Sensorfläche, um so mehr Probleme sind zu bewältigen. Dieses versuchen die Kamerahersteller mit unterschiedlichem Erfolg zu meistern.

Die daraus resultierenden Probleme, wie z.B. Rauschen und teils geringere Empfindlichkeit, sind neben einem oftmals zu geringen Auflösungsvermögen der Optik mit zu berücksichtigen, wenn wir uns heute eine neue Kamera kaufen wollen. Was nutzt ein Sensor der doppelt so viele kleine Details wiedergeben könnte, wenn durch den Flaschenhals Optik nur ein Teil der Informationen wirklich ankommt?

Es gilt, den Verwendungszweck zu bedenken. Die Eierlegendewollmilchsau gibt es nicht.

Für die meisten Bilder, die wir heute machen, reichen 6 Megapixel voll aus. Lieber das Modell mit der besseren Optik und dafür nicht die teurere Mehr-"Besser"-Megapixelvariante!

Wie ist jetzt die Kamera in der Lage mit nur den drei Farben

RGB nahezu das gesamte sichtbare Farbspektrum wieder zu geben?

Additives-Farbsystem (fspg2)

Sowohl die Fernseher, Scanner, Monitore und unsere Digitalkameras arbeiten mit diesen so genannten additiven Grundfarben

Rot -

Grün -

Blau .

Wenn man jetzt unsere Grafik ansehen, erkennen wir insgesamt nur 6 Farben

Rot -

Grün -

Blau -

Yellow (Grün + Rot) -

Magenta (Rot + Blau) und

Cyan (blau + grün), sowie

weiß und

schwarz.

Unsere bunte Welt hat aber sicherlich ein paar mehr Farben, als nur diese Acht! Durch die Möglichkeit unterschiedliche Helligkeitsstufen an jedem Sensorpixel individuell auszulesen, ermöglicht es uns echt-farbig zu fotografieren!

Am

Anfang des farbigen digitalen Zeitalters war man in der Lage an jedem Pixel 256 Hellikeitsstufen zu erfassen.

Wenn wir jetzt

256 x

256 x

256 Pixel mit einander multiplizieren, so erhalten wir rund 16,7 Mio. Farbnuancierungen - und das reicht aus, unsere sichtbare Welt zu zeigen. 256 sind 8bit = 1byte. Mit Hilfe eines bytes kann ich eine Farbe, einen Ton, eine Zahl oder einen Buchstaben im binären System - mit dem der Computer eben arbeitet

(Strom fließt oder kein Strom fließt - ja oder nein - an oder aus - 1 oder 0) darstellen.

Heutige Sensoren sind allerdings im Mittel- und Highend-Bereich in der Lage nicht nur diese 8bit pro Farbe = 24bit darzustellen. Wenn z.B. eine solche Kamera bis zu 16bit =

65536 Helligkeitsstufen pro

Rot -

Grün -

Blau-Farbe sensormäßig erfassen kann, dient es lediglich der besseren Differenzierung in den hellen, mittleren und dunkleren Bereichen eines Bildes. Die meisten Monitore und der Offsetdruck benötigen eh nur 8bit, d.h. nach einer professionellen Bildbearbeitung

im sogenannten Raw-Modus (16bit pro Farbe = 48bit) gespeicherter Bilder, habe ich sogar in scheinbar unterbelichteten Bereichen am Ende saubere Detailtrennungen, die ich bei 8bit

(jpg kann nur 8bit!) niemals hätte erzielen können.

Aber das braucht uns hier nicht zu interessieren, denn je mehr Informationen ein Bild enthält, um so größer der Speicherbedarf.

Für ein Forumsbild, das ja schnell geladen werden soll, müssen wir nach einem Mittelweg suchen.

Vorausgesetzt unser Bild ist gut ausgeleuchtet,

das heißt nicht nur von vorne hell gemacht mit dem aufgesteckten Blitz, so soll es alle wichtigen Details mit guter Schärfe enthalten. Dazu muss es die Farben sauber zeigen und durch die jpg-Speicherung

(dazu später in einem weiteren Beitrag mehr) möglichst nicht allzu viele Feinheiten verlieren.

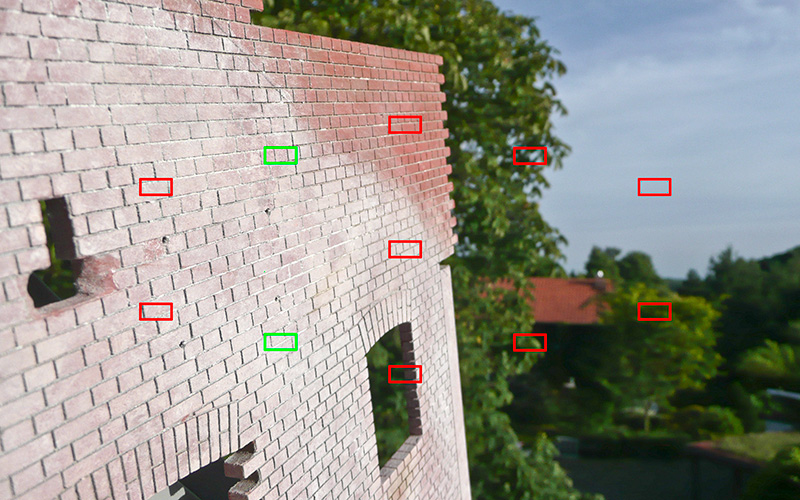

Eine kleine Ergänzung zu Rainer:

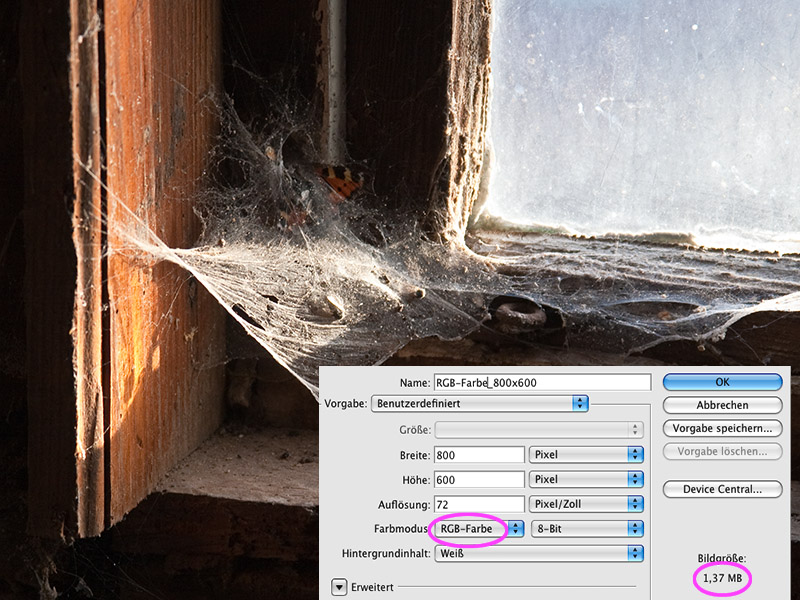

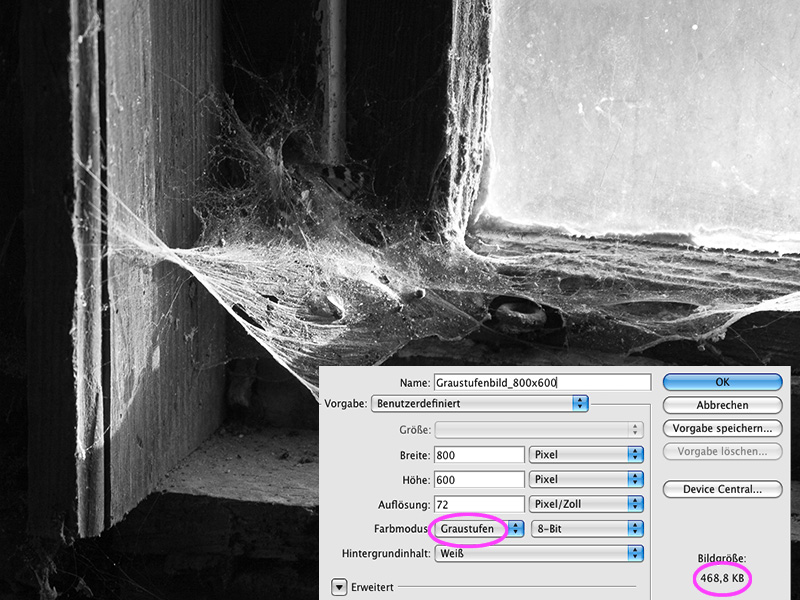

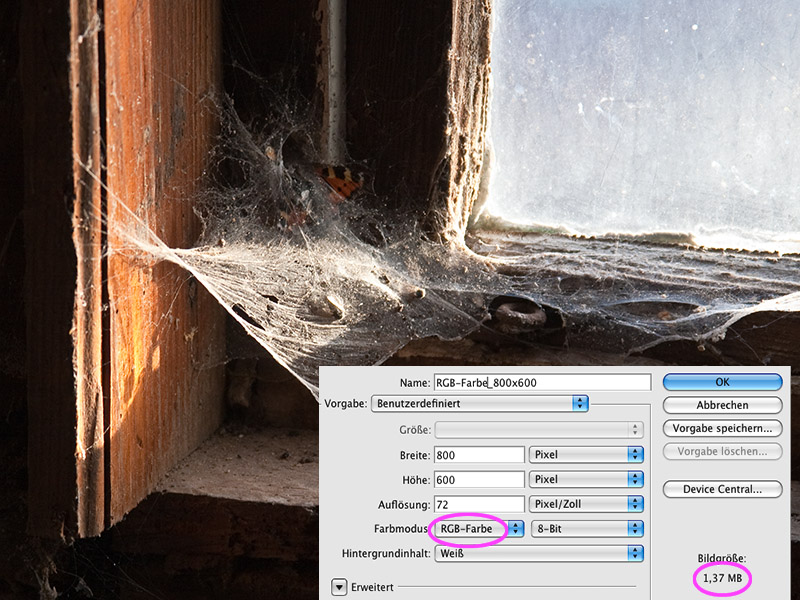

Für Bilder die hier im BBF gezeigt werden (800 * 600 Pixel = 0,48 Megapixel)

Die Abmessungen von 800 Pixel x 600 Pixel ergeben eine Fläche von 480 000 Pixeln (gleich0,48 Megapixel). Das sagt aber noch nichts über die tatsächliche

Dateigröße aus.

Wenn wir uns noch einmal den Sensor mit seinem

Bayerpattern-Mosaik erinnern, so hat jeder Pixel nur

eine Farbinformation vom Motiv, entweder

rot oder

grün oder

blau.

Mosaikbild (fspg2)

Dieses simulierte Mosaik ist zur Verdeutlichung viel zu groß!

Dieses simulierte Mosaik ist zur Verdeutlichung viel zu groß!

Benötigt aber werden von jeder Stelle

alle drei RGB-Informationen für jeden Pixel!!! Nach der Belichtung verarbeitet eine Software das Bild und interpoliert durch Vergleich der Nachbarpixel die vermutlich richtigen Farbinformationen. Dadurch hat jede

farbige Datei eine

dreifache Größe der vorhandenen Abmessung.

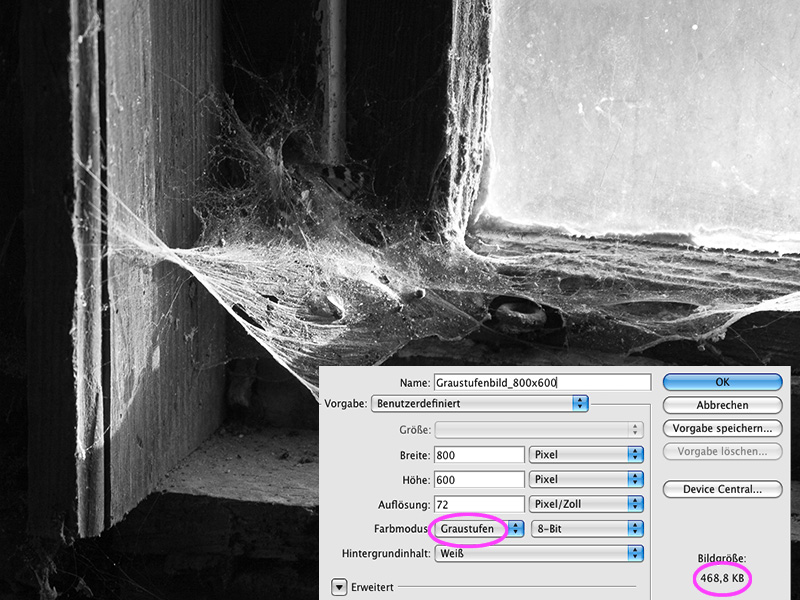

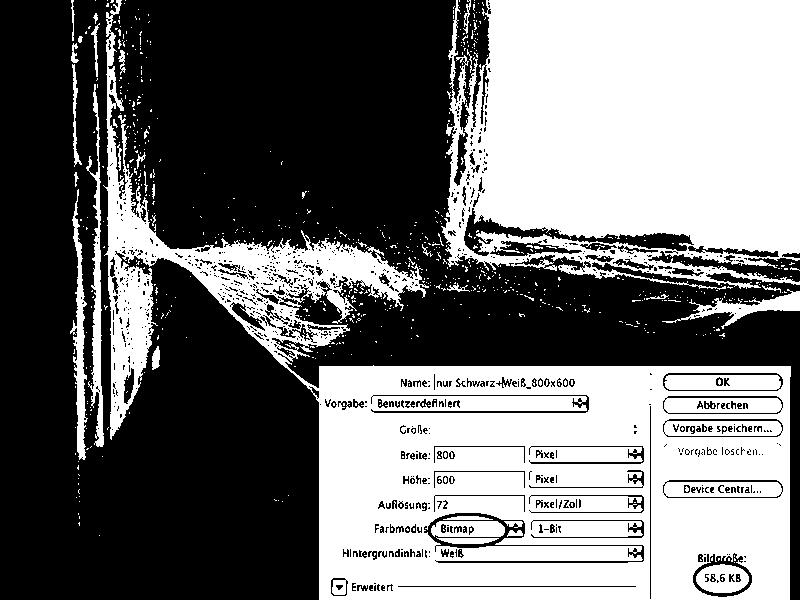

Die folgenden drei Bilder zeigen die Verhältnisse.

Groessenvergleich_RGB (fspg2)

Groessenvergleich_Graustufen

Groessenvergleich_Graustufen (fspg2)

Beim Graustufenbild hat ja jeder Pixel nur eine graue "Farbinformation" und hat dadurch tatsächlich gleiche Größe. Die leicht abweichende Zahl (468,8 kb) liegt an der internen Zählweise. Während wir mit 1000 = 1k

ilo rechnen, wird intern mit 1024 gezählt

(468,8kb /1000 * 1024 = 480kb) .

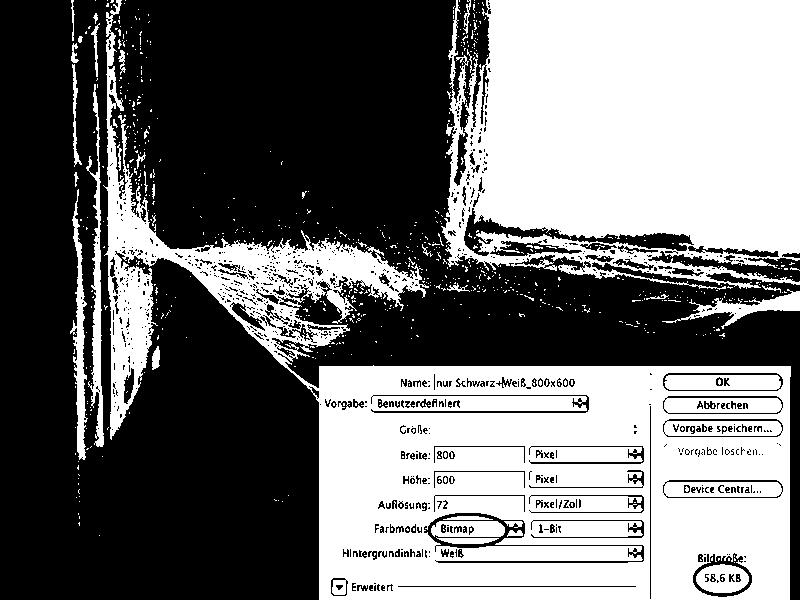

Groessenvergleich_S_W (fspg2)

Die Strichumsetzung hat ja nur noch

weiß und

schwarz als Information und entsprechend die kleinste Größe.

Soweit zur tatsächlichen Dateigröße, die sich von der jeweiligen

Speichergröße auf der Festplatte aber noch deutlich unterscheidet. Doch dazu in einer weiteren Beitrag mehr!

Wer sich etwas weiter über Sensortechnik informieren möchte, kann

hier weiter lesen.

Auch gut zu wissen:

"Wieviele Pixel braucht der Forianer"

Die Zukunft mit

neuem Mosaikfilter gibt es von Kodak?